Los ataques de envenenamiento de datos son técnicas para corromper inteligencias artificiales. Consisten en alterar los datos con los que se entrenan las IA de aprendizaje automático, causando comportamientos inesperados.

Estas técnicas se centran sobre todo en atacar a modelos generativos de texto a imagen con grandes conjuntos de datos de entrenamiento. Un argumento en contra de estas técnicas es que se supone que corromper el modelo requeriría de millones de muestras de datos envenenadas, pero parece ser que éste no es necesariamente el caso.

¿Qué es Nightshade?

Nightshade es una herramienta de envenenamiento de datos desarrollada por la Universidad de Chicago que requiere menos de 100 muestras para corromper un modelo. Además, al atacar un concepto, los efectos del envenenamiento pueden extenderse a conceptos relacionados con éste.

Consiste en envenenar las imágenes con cambios muy sutiles, que afectan a las IA pero no a las personas que ven las imágenes en Internet. Una imagen de un castillo generada por Nightshade sigue pareciendo un castillo para un humano, pero hay ligeras alteraciones a nivel de píxeles que enseñan al modelo a generar cosas que no son castillos.

Ejemplos

Algunos de los efectos que se muestran son imágenes donde al modelo se le pide un perro, y conforme avanza el envenenamiento de datos los perros se desdibujan cada vez más, convirtiéndose poco a poco en gatos. Lo mismo sucede con coches que se van pareciendo cada vez más a vacas. El modelo se acaba rompiendo también a veces de formas impredecibles, llevando a imágenes indescifrables.

Una ofensiva en defensa de los derechos de autor

Existe en estos momentos una asimetría de poder significativa entre las empresas de IA que entrenan modelos y los propietarios de contenido, que intentan proteger su propiedad intelectual. Las medidas actuales, como las listas de exclusión voluntaria y las directivas «no rastrear», son insuficientes y no se respetan universalmente.

Nightshade puede servir como un mecanismo de disuasión efectivo contra el incumplimiento de las directivas de «no rastreo».

El objetivo es que esta clase de ataques motiven a los entrenadores de modelos y a los creadores de contenidos a negociar, para llegar a acuerdos de licenciamiento transparentes y justos.

Cómo utilizar Nightshade

Todavía no hay una herramienta disponible para generar estas imágenes envenenadas, pero están trabajando en ello. Mientras tanto, hay otras alternativas disponibles como ‘NO AI’ y ‘ArtShield’.

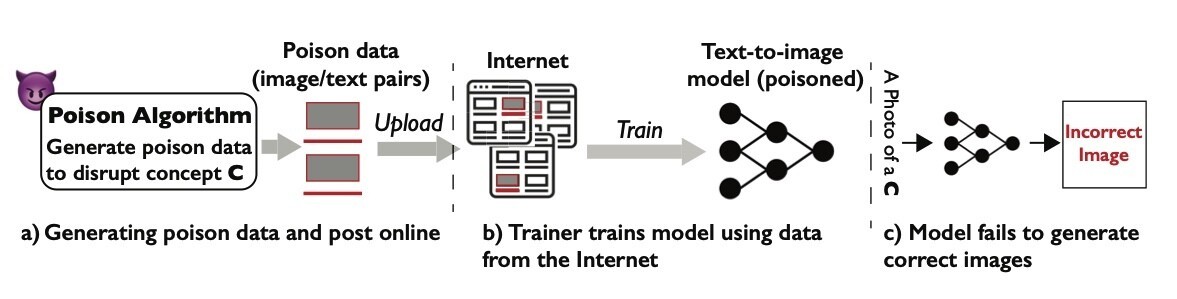

Así es como funciona el modelo:

- Se generan los datos envenenados para corromper el modelo y se suben a Internet.

- El entrenador usa imágenes de Internet de forma indiscriminada para componer su modelo de-texto-a-imagen, que ahora va envenenado.

- El modelo genera imágenes equivocadas.

Fuentes: